Inhaltsverzeichnis

Wird ständig erweitert

Installation, Konfiguration und Virtualisierung

Vorwort

Mit dem frei verfügbaren Software-Packet Proxmox lassen sich Betriebssysteme virtualisieren. Diese lassen sich sowohl als Virtual-Maschine wie auch in einem Container erstellen. Letzteres kann nur Applikationen der daruntes liegendem Betriebsystems ausführen. Container haben auch Zugriff auf die Systemlaufwerke.

Debian Buster (Debian 10) Installieren

Bemerkung für die Anleitung: Domain Name setzten, dieser wird bei der Netzwerkeinstellungen wieder benötigt.

UEFI oder BIOS Boot

ISO Datei downloaden

ISO Datei auf Stick kopieren und booten

Debian installieren

Richtig Partitionieren (Ein Beispiel)

Die Inbetriebnahme einer neuen Harddisk in Linux (Ubuntu, Proxmox, Denian) gestaltet sich in drei folgenden Schritten.

01. Sichtbar in Linux

Mit folgenden Befehlen lässt sich feststellen ob Linux die Harddisk erkennt hat.

lsblk # Listet alle erkannten Harddisk auf.

# Auch nicht gemountete Laufwerke werden angezeigt.

fdisk -l # Listet die Laufwerk mit allen Details auf.

blkid # Listet die Laufwerke auf mit deren UUID`s

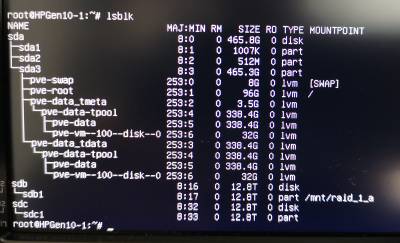

Weiter führende Informationen zum Befehl lsblk. Hierarchische Datendarstellung der installierten Harddisks.. Hier wie eine Ausgabe von lsblk aussehen könnte.

02. Partition erstellen

Als nächstes muss auf der Harddisk eine Partition erstellt werden. Dafür dient der Terminal-Befehl fdisk.

Um die Partitionierung mit fdisk zu starten geben muss die Harddisk mit angegeben werden. Hier ein Beispiel.

Um die Partitionierung mit fdisk zu starten geben muss die Harddisk mit angegeben werden. Hier ein Beispiel.

fdisk /dev/sdc

Nach dem Start kann mit der Taste [m] sich das Menü anzeigen lassen. Folgenden Schritte und Menupunkte sind zum erstellen bei einer z.b. 8TB Festplatte nötig.

1. Taste [g] Bei Festplatten grösser als 2TB sollte eine GPT Partition erstellt werden.

2. Taste [n] Eine neue Partition erstellen. Wenn die Standard Einstellunge belassen werden,

wird die gesamte Platte als eine Partition eingerichtet.

Als Typ wird `Linux filesystem` benutzt. Dies ist ein den meinsten Fällen das richtige Dateisystem.

3. Taste [i] Die Einstellunge werden angezeigt und können nochmals überprüft werden.

ACHTUNG folgender Befehl führt die Änderungen durch und alle Daten auf der Platte werden gelöscht!

4. Taste [w]

Liste der möglichen Partitions-Typen mit fdisk.

03. Dateisystem installieren

Nun muss noch ein Dateisystem auch die Partition gebracht werden. Dabei wählt man die eben erstellte Partition aus. Mit lsblk lässt sich nun die Partition leicht finden.

root@HPGen10-1://# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 465.8G 0 disk

├─sda1 8:1 0 1007K 0 part

├─sda2 8:2 0 512M 0 part

└─sda3 8:3 0 465.3G 0 part

├─pve-swap 253:0 0 8G 0 lvm [SWAP]

├─pve-root 253:1 0 96G 0 lvm /

├─pve-data_tmeta 253:2 0 3.5G 0 lvm

│ └─pve-data-tpool 253:4 0 338.4G 0 lvm

│ ├─pve-data 253:5 0 338.4G 0 lvm

│ └─pve-vm--100--disk--0 253:6 0 32G 0 lvm

└─pve-data_tdata 253:3 0 338.4G 0 lvm

└─pve-data-tpool 253:4 0 338.4G 0 lvm

├─pve-data 253:5 0 338.4G 0 lvm

└─pve-vm--100--disk--0 253:6 0 32G 0 lvm

sdb 8:16 0 12.8T 0 disk

└─sdb1 8:17 0 12.8T 0 part /mnt/raid_1_a

sdc 8:32 0 12.8T 0 disk

└─sdc1 8:33 0 12.8T 0 part /mnt/raid_1_b

root@HPGen10-1://#

In diese Beispiel sind es z.B. die Laufwerke sdb1 und/oder sdc1.

04. Harddisk mounten

Nachdem eine Partition auf dem Laufwerk erstellt wurde muss diese noch mit einem Dateisystem versehen werden. Bei den derzeit auf dem Markt erhältichen Grössen von mehr als 2TB sollte nur noch das ext4 Format benutzt werden. Dies kann mit folgendem Befehl erstellt werden.

mkfs -t ext4 /dev/sdb1

Das jetzt partitionierte und mit einem Dateisystem versehene Laufwerk kann immer noch nicht benutzt werden. Dazu muss es zuerst noch gemountet werden. Dies kann sowohl temporär (nur bis zum nächsten Systemstart) wie auch permanent erfolgen. Für den temporären Einsatz müssen folgende Schritte unternommen werden.

Temporäres mounten

# Einen Dateipfad erstellen auf das dann das Laufwerk gemountet wird. # Die Daten sind dann unter diesem Ordner sichtbar. mkdir /mnt/raid_1_a # Das Mounten auf den Dateipfaht: mount /dev/sdc1 /mnt/raid_1_a # Wie schon erwähnt ist das Laufwerk nach einem Systemstart nicht mehr sichtbar.

Laufwerk permanent mounten

Permanent mounten heisst, es muss ein Eintrag in die Datei fstab gemacht werden. Dabei sollte dies über die UUID des Laufwerks erfolgen. Dies erweist sich in der Praxis als stabieler. Als erstes lassen wir uns die UUID`s der Laufwerke anzeigen.

blkid # Hier ein Ausgabebeispiel: /dev/sda2: UUID="D21B-3B80" TYPE="vfat" PARTUUID="e2cc8236-bedd-401f-92d4-5d5b545ab07a" /dev/sda3: UUID="B0bflt-4XCD-0K08-k6Nf-cu3Q-WkNs-BpnHlK" TYPE="LVM2_member" PARTUUID="c0e756da-59f9-4b61-8a23-8c4b03cb5477" /dev/sdb1: UUID="aa30cd31-f6b2-474f-88d8-3b6e5d3fef16" TYPE="ext4" PARTUUID="30aec432-8d50-8445-81ae-80f9f953ae74" /dev/sdc1: UUID="f60bb669-c14d-45b5-b67e-24e2e96ba8eb" TYPE="ext4" PARTUUID="69139bf6-7ac5-f24f-a9ea-e733ea6a423c" /dev/mapper/pve-swap: UUID="0143e34e-3dd3-42ed-9015-9dc2c7039e9e" TYPE="swap" /dev/mapper/pve-root: UUID="a76bad07-f064-4476-8602-6b8e981e0b35" TYPE="ext4" /dev/sda1: PARTUUID="1b574b4a-a223-4097-8788-f5a181407f0e" /dev/mapper/pve-vm--100--disk--0: PTUUID="0d3cae48-0ec6-405e-88d7-ff7916f0d536" PTTYPE="gpt"

Eintrag in die Datei fstab

In der Datei fstab werden alle Laufwerke die gemountet werden sollen eingetragen. Diese Datei lässt sich mit jedem Texteditor bearbeiten. Ich beforzuge hier nano da dieses am einfachsten zu bedienen ist.

nano /etc/fstab //öffnet fstab

Proxmox installieren

1. Debian aktualisieren

2. Netzwerkkarte einstellen

Da Proxmox ein WEB-Interface für die Verwaltung mitliefert, müssen wir Debian von aussen zugänglich machen. Dazu setzen wir eine fixe IP-Adresse der Netzwerkkarte (ohne DHCP) und vergeben auch den Hostnamen. Alternativ kann auch die IP-Adresse vom DHCP-Server vergeben werden. Sorgen Sie aber dafür, dass immer die gleiche IP-Adresse (reservieren) vergeben wird. Ersetzten Sie im Codebeispiel den Domain-Name example.com durch den Domain-Namen den Sie bei der Installation von Debian vergeben haben.

sudo hostnamectl set-hostname prox6node01.example.com --static # Ersetzen Sie example.com d. ihre Domain-Name !! echo "10.1.1.10 prox6node01.example.com prox6node01" | sudo tee -a /etc/hosts # Vergeben des Hostsnamens mit der IP-Adresse

3. Key downloaden

Um sicher zu stellen das wir nur originale Software bzw Updates herunterladen (also keine gehackten oder manipulierte) benötigen wir einen sog. GPG-Key. Dieser Key wird vom Softwarehersteller berechnet und zur Verfügung gestellt. Damit werden später alle Updaten und Upgrades auf Echtheit überprüft. Es stehen folgende zwei Möglichkeiten offen.

Möglichkeit 1

wget -qO - http://download.proxmox.com/debian/proxmox-ve-release-6.x.gpg | sudo apt-key add - # Den Key downloaden & speichern

Möglichkeit 2 (meine bevorzugte Methode)

wget http://download.proxmox.com/debian/proxmox-ve-release-6.x.gpg # Key-Datei herunterladen. sudo mv proxmox-ve-release-6.x.gpg /etc/apt/trusted.gpg.d/proxmox-ve-release-6.x.gpg # Den Key in die Key-DB hinzufügen. chmod +r /etc/apt/trusted.gpg.d/proxmox-ve-release-6.x.gpg # Die Key-Datei mit Lese-Rechten versehen

4. Link für den Software-Download & Updates in die Liste eintragen.

echo "deb http://download.proxmox.com/debian/pve buster pve-no-subscription" | sudo tee /etc/apt/sources.list.d/pve-install-repo.list

5. Das System nun mit der neuen Softwarequelle in der Liste updaten.

sudo apt update && sudo apt dist-upgrade # Es wird nach neuen Versionen gesucht und installiert.

6. Optional kann das Ceph-Packet zur Systemüberwachung usw. installiert werden.

Weitere Informationen zu Ceph-Nautilus.

echo "deb http://download.proxmox.com/debian/ceph-nautilus buster main" | sudo tee /etc/apt/sources.list.d/ceph.list

7. Die Installation von Proxmox.

sudo apt install proxmox-ve postfix open-iscsi

8. Das System neu starten.

sudo reboot

Proxmox WEB-Interface aufrufen und bedienen

Nach dem System-Start stellt Proxmox ein WEB Interface zur verfügung und kann mit https://ip-address:8006 aufgerufen werden. Achtung: https nicht http!

Für die Bedienung der Oberfläche von Proxmox stehen verschiedene Quellen offen. Diese stellen die ISO-Dateien zum Download bereit, sind Online-Handbücher und Offline-Handbücher als PDF-Datei oder als E-Book zu finden.

Eine Harddisk von Proxmox zur einer virtuelle Maschine durchreichen

Jede Harddisk oder SSD lässt sich in wenigen Schritten auch für die VM (Virtuelle Maschine) verfügbar machen. Dabei spielt es nach meiner Erfahrung nach keine Rolle ob die unter Proxmox bereits gemountet ist oder nicht. Mann kann sowohl eine ganze Harddisk wie auch nur eine Partition durchreichen.

1. Installieren einer virtuellen Maschine.

Dies beschreibe ich weiter oben. Hilfe bekommt man auch bei Proxmox HHS aber auch ApfelCast.

2. Virtuelle Maschine stoppen.

Vor der „Durchreichung“ muss die VM mit folgendem Befehl gestoppt werden.

qm stop <vmnr> //<vmnr> = nummer der VM. qm list //Zeigt alle VM's und deren Status an.

Ausgabebeispiel.

root@HPGen10-1:~# qm list

VMID NAME STATUS MEM(MB) BOOTDISK(GB) PID

100 UbuntuServer running 4096 32.00 1326

101 Windows10DEX64 stopped 4032 32.00 0

root@HPGen10-1:~#

3. ID der Harddisk feststellen (Variante A).

Für die Konfiguration der VM benötigen wir noch die ID der Harddisk. Diese lässt sich mit folgendem Befehl anzeigen.

ls /dev/disk/by-id //Listet alle Laufwerks-ID`s auf.

Die Ausgabe auf dem Terminal kann aber ganz schön verwirrend sein.

root@HPGen10-1:~# ls /dev/disk/by-id ata-Hitachi_HDT721010SLA360_STF601MH01ZEVB ata-Hitachi_HDT721010SLA360_STF601MH01ZEVB-part1 dm-uuid-LVM-9z8r9Go9vF5jmj0dGmYPeGSNQDEdALcO3VLDCfOJ9oYY7Ulnhgp1Vf3f4GWPNQ09 dm-uuid-LVM-9z8r9Go9vF5jmj0dGmYPeGSNQDEdALcOIWY0hPtNmqEqQtnIroyEZ3O4IR4eybDA ata-MARVELL_Raid_VD_aa0db37a98091010 ata-MARVELL_Raid_VD_aa0db37a98091010-part1 lvm-pv-uuid-B0bflt-4XCD-0K08-k6Nf-cu3Q-WkNs-BpnHlK usb-WD_My_Book_Duo_0A10_575541323730353030323131-0:0 usb-WD_My_Book_Duo_0A10_575541323730353030323131-0:0-part1 usb-WD_My_Book_Duo_0A10_575541323730353030323131-0:0-part2 ata-MARVELL_Raid_VD_f5825f4a35330010 ata-MARVELL_Raid_VD_f5825f4a35330010-part1 ata-Samsung_SSD_860_EVO_500GB_S3Z2NB1KB00429R ata-Samsung_SSD_860_EVO_500GB_S3Z2NB1KB00429R-part1 ata-Samsung_SSD_860_EVO_500GB_S3Z2NB1KB00429R-part2 ata-Samsung_SSD_860_EVO_500GB_S3Z2NB1KB00429R-part3 usb-WD_My_Book_Duo_0A10_575541323730353030323131-0:1 usb-WD_My_Book_Duo_0A10_575541323730353030323131-0:1-part1 usb-WD_My_Book_Duo_0A10_575541323730353030323131-0:1-part2 wwn-0x5000cca349c0e6aa wwn-0x5000cca349c0e6aa-part1 ata-WDC_WD20EARX-32PASB0_WD-WCAZAE220245 ata-WDC_WD20EARX-32PASB0_WD-WCAZAE220245-part1 wwn-0x50014ee2b1b77315 wwn-0x50014ee2b1b77315-part1 dm-name-pve-root dm-name-pve-swap wwn-0x5002538e40993a1e wwn-0x5002538e40993a1e-part1 wwn-0x5002538e40993a1e-part2 wwn-0x5002538e40993a1e-part3 dm-name-pve-vm--100--disk--0 dm-name-pve-vm--101--disk--0 dm-uuid-LVM-9z8r9Go9vF5jmj0dGmYPeGSNQDEdALcO2E9rC3xHJXRTQ3qa69Sdmrj5BGEdJf20 dm-uuid-LVM-9z8r9Go9vF5jmj0dGmYPeGSNQDEdALcO3MqrK8mhXtlfyqX3frJrXPxwHHFH1EX9

Um die Laufwerke auch den ID`s zuordnen zu können benötigen wir einen weiteren Befehl. Mit dem Befehl lsblk mit den weiteren Parametern lassen sich detailierte Informationen ausgeben. Durch vergleichen der Daten MODEL, HCTL und SERIAL sollte ein Quervergeleich mit obiger Ausgabe möglich sein (gelb markierte Linien).

lsblk -V // Zeigt die Version von lsblk an:

lsblk from util-linux 2.33.1 // Nächster Befehl funktioniert nur mit dieser Version!

lsblk -o path,model,hctl,mountpoint,serial // Die Reihenfolge der Parameter spiehlt keine Rolle.

Zum Befehl lsblk sind weiter Informationen unter Ubuntu oder Debian.

Hier ein Beispiel eines Linux Dateisystems.

root@HPGen10-1:~# lsblk -o path,model,hctl,mountpoint,serial PATH MODEL HCTL MOUNTPOINT SERIAL /dev/sda Samsung_SSD_860_EVO_500GB 0:0:0:0 S3Z2NB1KB00429R /dev/sda1 /dev/sda2 /dev/sda3 /dev/sdb MARVELL_Raid_VD 1:0:0:0 f5825f4a35330010 /dev/sdb1 /mnt/raid_1_a /dev/sdc MARVELL_Raid_VD 3:0:0:0 aa0db37a98091010 /dev/sdc1 /mnt/raid_1_b /dev/sdd Hitachi_HDT721010SLA360 9:0:0:0 STF601MH01ZEVB /dev/sdd1 /mnt/usb_lw_2tb_b /dev/sde WDC_WD20EARX-32PASB0 10:0:0:0 WD-WCAZAE220245 /dev/sde1 /mnt/usb_lw_2tb_a /dev/sdf My_Book_Duo_0A10 11:0:0:0 575541323730353030323131 /dev/sdf1 /dev/sdf2 /mnt/usb_lw_8tb_b /dev/sdg My_Book_Duo_0A10 11:0:0:1 575541323730353030323131 /dev/sdg1 /dev/sdg2 /mnt/usb_lw_8tb_a /dev/mapper/pve-swap [SWAP] /dev/mapper/pve-root / /dev/mapper/pve-data_tmeta /dev/mapper/pve-data_tdata /dev/mapper/pve-data-tpool /dev/mapper/pve-data-tpool /dev/mapper/pve-data /dev/mapper/pve-data /dev/mapper/pve-vm--100--disk--0 /dev/mapper/pve-vm--100--disk--0 /dev/mapper/pve-vm--101--disk--0 /dev/mapper/pve-vm--101--disk--0

In meinem Beispiel möchte ich einer der beiden USB Laufwerken mit dem Namen MyBook_Dual_0A10 zur VM durchreichen. Beiden habe gleiche Namen und Serial Nummern. Diese unterscheiden sich aber in der HCTL Nummer. Meine gesuchtes USB Laufwerk hat die HCTL Nr: 11:0:0:1.

Bei der Ausgabe von ls /dev/disk/by-id kann ich nun die beiden letzten Ziffern vergleich und finde damit die ID Nummer:

usb-WD_My_Book_Duo_0A10_575541323730353030323131-0:1

3. ID der Harddisk feststellen (Variante B).

Als Erstens lassen wir uns mit den Befehl lsblk die erkannten Harddisks anzeigen:

root@HPGen10-1:~# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 465.8G 0 disk

├─sda1 8:1 0 1007K 0 part

├─sda2 8:2 0 512M 0 part

└─sda3 8:3 0 465.3G 0 part

├─pve-swap 253:0 0 8G 0 lvm [SWAP]

├─pve-root 253:1 0 96G 0 lvm /

├─pve-data_tmeta 253:2 0 3.5G 0 lvm

│ └─pve-data-tpool 253:4 0 338.4G 0 lvm

│ ├─pve-data 253:5 0 338.4G 0 lvm

│ ├─pve-vm--100--disk--0 253:6 0 32G 0 lvm

│ ├─pve-vm--101--disk--0 253:7 0 34G 0 lvm

│ ├─pve-vm--102--disk--0 253:8 0 32G 0 lvm

│ ├─pve-vm--103--disk--0 253:9 0 34G 0 lvm

│ └─pve-vm--104--disk--0 253:10 0 128G 0 lvm

└─pve-data_tdata 253:3 0 338.4G 0 lvm

└─pve-data-tpool 253:4 0 338.4G 0 lvm

├─pve-data 253:5 0 338.4G 0 lvm

├─pve-vm--100--disk--0 253:6 0 32G 0 lvm

├─pve-vm--101--disk--0 253:7 0 34G 0 lvm

├─pve-vm--102--disk--0 253:8 0 32G 0 lvm

├─pve-vm--103--disk--0 253:9 0 34G 0 lvm

└─pve-vm--104--disk--0 253:10 0 128G 0 lvm

sdb 8:16 0 12.8T 0 disk

└─sdb1 8:17 0 12.8T 0 part /mnt/raid_1_a

sdc 8:32 0 12.8T 0 disk

└─sdc1 8:33 0 12.8T 0 part /mnt/raid_1_b

sdd 8:48 0 1.8T 0 disk

└─sdd1 8:49 0 1.8T 0 part /mnt/usb_lw_2tb_b

Nehmen wir mal an wir wollen die Harddisk sdb mit der Partition sdb1 zur VM durchreichen (gelb markierte Linien).

Mit dem Befehl ls -al /dev/disk/by-id lassen wir uns die Harddisk-id's anzeigen.

root@HPGen10-1:~# ls -al /dev/disk/by-id total 0 drwxr-xr-x 2 root root 660 Jun 21 11:12 . drwxr-xr-x 7 root root 140 Jun 21 11:12 .. lrwxrwxrwx 1 root root 9 Jun 21 11:12 ata-Hitachi_HDT721010SLA360_STF601MH01ZEVB -> ../../sdd lrwxrwxrwx 1 root root 10 Jun 21 11:12 ata-Hitachi_HDT721010SLA360_STF601MH01ZEVB-part1 -> ../../sdd1 lrwxrwxrwx 1 root root 9 Jun 21 11:12 ata-MARVELL_Raid_VD_aa0db37a98091010 -> ../../sdc lrwxrwxrwx 1 root root 10 Jun 21 11:12 ata-MARVELL_Raid_VD_aa0db37a98091010-part1 -> ../../sdc1 lrwxrwxrwx 1 root root 9 Jun 21 11:12 ata-MARVELL_Raid_VD_f5825f4a35330010 -> ../../sdb lrwxrwxrwx 1 root root 10 Jun 21 11:12 ata-MARVELL_Raid_VD_f5825f4a35330010-part1 -> ../../sdb1 lrwxrwxrwx 1 root root 9 Jun 21 11:12 ata-Samsung_SSD_860_EVO_500GB_S3Z2NB1KB00429R -> ../../sda lrwxrwxrwx 1 root root 10 Jun 21 11:12 ata-Samsung_SSD_860_EVO_500GB_S3Z2NB1KB00429R-part1 -> ../../sda1 lrwxrwxrwx 1 root root 10 Jun 21 11:12 ata-Samsung_SSD_860_EVO_500GB_S3Z2NB1KB00429R-part2 -> ../../sda2 lrwxrwxrwx 1 root root 10 Jun 21 11:12 ata-Samsung_SSD_860_EVO_500GB_S3Z2NB1KB00429R-part3 -> ../../sda3 lrwxrwxrwx 1 root root 10 Jun 21 11:12 dm-name-pve-root -> ../../dm-1 lrwxrwxrwx 1 root root 10 Jun 21 11:12 dm-name-pve-swap -> ../../dm-0 lrwxrwxrwx 1 root root 10 Jun 21 11:12 dm-name-pve-vm--100--disk--0 -> ../../dm-6 lrwxrwxrwx 1 root root 10 Jun 21 11:12 dm-name-pve-vm--101--disk--0 -> ../../dm-7 lrwxrwxrwx 1 root root 10 Jun 21 11:12 dm-name-pve-vm--102--disk--0 -> ../../dm-8 lrwxrwxrwx 1 root root 10 Jun 21 11:12 dm-name-pve-vm--103--disk--0 -> ../../dm-9 lrwxrwxrwx 1 root root 11 Jun 21 11:12 dm-name-pve-vm--104--disk--0 -> ../../dm-10 lrwxrwxrwx 1 root root 10 Jun 21 11:12 dm-uuid-LVM-9z8r9Go9vF5jmj0dGmYPeGSNQDEdALcO2E9rC3xHJXRTQ3qa69Sdmrj5BGEdJf20 -> ../../dm-1 lrwxrwxrwx 1 root root 10 Jun 21 11:12 dm-uuid-LVM-9z8r9Go9vF5jmj0dGmYPeGSNQDEdALcO3MqrK8mhXtlfyqX3frJrXPxwHHFH1EX9 -> ../../dm-0 lrwxrwxrwx 1 root root 10 Jun 21 11:12 dm-uuid-LVM-9z8r9Go9vF5jmj0dGmYPeGSNQDEdALcO3VLDCfOJ9oYY7Ulnhgp1Vf3f4GWPNQ09 -> ../../dm-7 lrwxrwxrwx 1 root root 10 Jun 21 11:12 dm-uuid-LVM-9z8r9Go9vF5jmj0dGmYPeGSNQDEdALcOIWY0hPtNmqEqQtnIroyEZ3O4IR4eybDA -> ../../dm-6 lrwxrwxrwx 1 root root 10 Jun 21 11:12 dm-uuid-LVM-9z8r9Go9vF5jmj0dGmYPeGSNQDEdALcONP8NrMxRdO8YQBuOLj8sVJztk259Ohai -> ../../dm-8 lrwxrwxrwx 1 root root 10 Jun 21 11:12 dm-uuid-LVM-9z8r9Go9vF5jmj0dGmYPeGSNQDEdALcOQjuUoDJ8DEl3ivWbs4B3fgN75lmOije1 -> ../../dm-9 lrwxrwxrwx 1 root root 11 Jun 21 11:12 dm-uuid-LVM-9z8r9Go9vF5jmj0dGmYPeGSNQDEdALcOSwSfNinaYOa01tANIreY7M637sUBrKSo -> ../../dm-10 lrwxrwxrwx 1 root root 10 Jun 21 11:12 lvm-pv-uuid-B0bflt-4XCD-0K08-k6Nf-cu3Q-WkNs-BpnHlK -> ../../sda3 lrwxrwxrwx 1 root root 9 Jun 21 11:12 wwn-0x5000cca349c0e6aa -> ../../sdd lrwxrwxrwx 1 root root 10 Jun 21 11:12 wwn-0x5000cca349c0e6aa-part1 -> ../../sdd1 lrwxrwxrwx 1 root root 9 Jun 21 11:12 wwn-0x5002538e40993a1e -> ../../sda lrwxrwxrwx 1 root root 10 Jun 21 11:12 wwn-0x5002538e40993a1e-part1 -> ../../sda1 lrwxrwxrwx 1 root root 10 Jun 21 11:12 wwn-0x5002538e40993a1e-part2 -> ../../sda2 lrwxrwxrwx 1 root root 10 Jun 21 11:12 wwn-0x5002538e40993a1e-part3 -> ../../sda3 root@HPGen10-1:~#

Die Ausgabe zeigt uns nun die Harddisk wie auch die Partition mit dem Verweis auf ../../sdb bzw. ../../sdb1 an. Somit können wir als Harddisk-Id ata-MARVELL_Raid_VD_f5825f4a35330010 feststellen und wenn nötig können wir auch nur die Partition mit der ID ata-MARVELL_Raid_VD_f5825f4a35330010-part1 lesen bzw. benutzen.

4. Konfiguration der VM.

Nun müssen wir nur noch die gefundene ID (Harddisk) durchreichen bzw. die VM konfigurieren. Dies erledigen wir mit folgendem Terminal Befehl.

qm set 100 -virtio0 /dev/disk/by-id/usb-WD_My_Book_Duo_0A10_575541323730353030323131-0:1 //Variante A, USB Laufwerk qm set 100 -virtio1 /dev/disk/by-id/ata-MARVELL_Raid_VD_f5825f4a35330010 //Variante B, Internes Laufwerk

Die Virtuelle Maschine (VM) mit der Nummer 100 wird ein virtio0 Laufwerkstreiber für das Laufwerk benutzt. Zu Beachten ist, dass wenn mehrer Laufwerke durchgereicht werden sollen auch der Index des Laufwerkstreibers erhöht werden muss. Z.B. virtio1, virtio2, virtio3 usw.

5. VM starten.

Anschliessend müssen wir die VM starten.

qm start 100

Nun sollte das Laufwerk in der Konsole der VM, vorausgesetzt es handelt sich um ein linux Betriebsystem, mit dem Befehl lsblk sehen.

root@hpgen10-1:~# root@hpgen10-1:~# lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT loop0 7:0 0 93,9M 1 loop /snap/core/9066 loop1 7:1 0 97M 1 loop /snap/core/9289 sda 8:0 0 32G 0 disk ├─sda1 8:1 0 1M 0 part └─sda2 8:2 0 32G 0 part / sr0 11:0 1 1024M 0 rom vda 252:0 0 12,8T 0 disk └─vda1 252:1 0 12,8T 0 part root@hpgen10-1:~#

Die durchgereichte Harddisk ist hier als vda mit der Partiton vda1 sichtbar. Ab hier können Sie die Harddisk wie gewohnt mounten.

Nach der Installation:

Nach der Installation sollten Sie folgende Schritte (optional) durchführen.

1. Servicearbeiten

Harddisk prüfen

sudo e2fsck -cfpv /dev/sdb1 // Ersetzen Sie sdb1 mit Ihrem Laufwerk //oder fsck -c -y /dev/sdb1 // Ersetzen Sie sdb1 mit Ihrem Laufwerk, mit y=autorepair

2. Nützliche Programme

htop

//Installation mit:

sudo apt-get install htop

iftop

//Installation mit:

sudo apt-get install iftop

glances

//Installation mit:

sudo apt-get install glances

hwinfo

3. Upgrade von Proxmox V6.1 nach V6.2

Mit folgenden Schritten können Sie die Proxmox Version 6.1 auf Version 6.2 „heben“.

An erster Stelle ergänzen wir die Liste der Links für die Updates. Diese Liste finden wir in folgenden Ordner und wir mit dem Texteditor nano geöffnet.

nano /etc/apt/sources.list

Hier wird der Inhalt der Datei angezeigt. Die markierten Zeilen müssen gegebenenfalls hinzugefügt werden.

Nun kann mit folgendem Befehl mit dem Update begonnen werden.

apt update && apt dist-upgrade

Anschliessen müssen Sie das System neu starten:

reboot